Performantieanalyse van Iteratieve Reconstructiealgoritmes ...

Transcript of Performantieanalyse van Iteratieve Reconstructiealgoritmes ...

Joachim Buyse

reconstructiealgoritmes voor microCTPerformantieanalyse van iteratieve

Academiejaar 2011-2012Faculteit Ingenieurswetenschappen en ArchitectuurVoorzitter: prof. dr. ir. Jan Van CampenhoutVakgroep Elektronica en Informatiesystemen

Master in de ingenieurswetenschappen: computerwetenschappen Masterproef ingediend tot het behalen van de academische graad van

Begeleider: Bert VandeghinstePromotoren: prof. Christian Vanhove, prof. dr. Stefaan Vandenberghe

Joachim Buyse

reconstructiealgoritmes voor microCTPerformantieanalyse van iteratieve

Academiejaar 2011-2012Faculteit Ingenieurswetenschappen en ArchitectuurVoorzitter: prof. dr. ir. Jan Van CampenhoutVakgroep Elektronica en Informatiesystemen

Master in de ingenieurswetenschappen: computerwetenschappen Masterproef ingediend tot het behalen van de academische graad van

Begeleider: Bert VandeghinstePromotoren: prof. Christian Vanhove, prof. dr. Stefaan Vandenberghe

De auteur en promotoren geven de toelating deze scriptie voor consultatie beschikbaar te stellen

en delen ervan te kopieren voor persoonlijk gebruik. Elk ander gebruik valt onder de beperkingen

van het auteursrecht, in het bijzonder met betrekking tot de verplichting uitdrukkelijk de bron

te vermelden bij het aanhalen van resultaten uit deze scriptie.

The author and promoters give the permission to use this thesis for consultation and to copy

parts of it for personal use. Every other use is subject to the copyright laws, more specifically

the source must be extensively specified when using from this thesis.

Gent, Juni 2012

De promotoren De begeleider De auteur

Prof. dr. C. Vanhove ir. Bert Vandeghinste Joachim Buyse

Prof. dr. S. Vandenberghe

Voorwoord

“Most of us, swimming against the tides of trouble the world knows nothing about,

need only a bit of praise or encouragement - and we will make the goal.”

Jerome Fleishman

Dit werk had nooit kunnen worden wat het is, zonder de hulp en steun van zo veel mensen. Ik

zou hierbij iedereen die op een of andere manier een bijdrage heeft geleverd van harte willen

bedanken.

In het bijzonder wil ik mijn dank uitdrukken aan mijn begeleider Bert Vandeghinste, die ondanks

zijn eigen doctoraat toch steeds de tijd vond om me te helpen wanneer ik een probleem had.

Ook wil ik mijn promotoren Stefaan Vandenberghe en Christian Vanhove bedanken om dit

thesisonderwerp speciaal voor mij op te stellen. Zonder jullie was dit werk er niet geweest.

Ik wil ook mijn ouders en zus bedanken voor de enorme steun en vertrouwen die ze mij gegeven

hebben. Jullie hielpen me steeds de moed te vinden om voort te gaan. Tot slot wil ik ook nog

mijn vrienden bedanken om altijd klaar te staan voor de broodnodige ontspanning en plezier,

wanneer ik er even tussenuit moest.

Aan iedereen, bedankt!

Joachim Buyse

v

Performantieanalyse van IteratieveReconstructiealgoritmes voor microCT

door

Joachim Buyse

Masterproef ingediend tot het behalen van de academische graad van

Master in de ingenieurswetenschappen: Computerwetenschappen

Academiejaar 2011-2012

Promotoren: prof. dr. Christian Vanhove, prof. dr. Stefaan Vandenberghe

Begeleider: ir. Bert Vandeghinste

Faculteit Ingenieurswetenschappen en Architectuur

Universiteit Gent

Vakgroep Elektronica en Informatiesystemen

Voorzitter: prof. dr. ir. Jan Van Campenhout

Samenvatting

In dit werk wordt de implementatie van 5 iteratieve reconstructiealgoritmes – SART, OS-

SART, OS-EM, OS-ISRA en OS-MLTR – voor microCT op GPU vergeleken met analytische

reconstructie. De algoritmes worden aan de hand van een water, een laag contrast en een

draadfantoom beoordeeld op ruisbestendigheid, contrast, spatiale resolutie en uitvoeringstijd.

Het blijkt dat OS-MLTR superieure resultaten levert op gebied van ruisbestendigheid en

contrast, wanneer als startbeeld een iteratie op een lagere resolutie uitgevoerd wordt. OS-

ISRA presteert onafhankelijk van het startbeeld het beste op spatiale resolutie, maar door

de lage ruisbestendigheid van het algoritme zijn de resultaten van analytische reconstructie,

OS-SART en OS-MLTR aantrekkelijker. Analytische reconstructie blijft nog steeds minstens

dubbel zo snel als de iteratieve algoritmes, maar hun uitvoeringstijden, die voor OS-ISRA en

OS-MLTR zelfs onder de 20 minuten liggen, zijn niet langer onpraktisch. Verder onderzoek

naar het versnellen van backprojecties kan deze tijden nog gevoelig verbeteren.

Trefwoorden: Performantie, Iteratieve Reconstructie, microCT

Performantieanalyse van IteratieveReconstructiealgoritmes voor microCT

Joachim BuyseSupervisors: Bert Vandeghinste, Christian Vanhove, Stefaan Vandenberghe

Abstract—In recent years, iterative reconstruction for microCThas become increasingly popular. With the introduction of generalpurpose GPUs, iterative techniques could become a valuablealternative for analytical reconstruction. In this work, severaliterative reconstruction algorithms implemented on GPU werecompared to FBP analytical reconstruction. Based on a water, alow contrast and a wire phantom, we compared the performanceof the different algorithms based on noise, contrast, spatialresolution and execution time. For each of these parameters wealso examined the influence of the start image. We found thatOS-MLTR and OS-SART in combination with a multiresolutionalstart image have the best noise resistance and contrast. Amongthe iterative algorithms, OS-ISRA has the best spatial resolution,yet because of its low noise resistance, analytical reconstruction,OS-MLTR and OS-SART create more visually pleasing images.Analytical reconstruction remains fastest, yet more research onfaster backprojection could speed up iterative algorithms to thesame level.

Index Terms—microCT, iterative, reconstruction, GPU, perfor-mance

I. INTRODUCTION

ANALYTICAL reconstruction has been the de facto stan-dard in CT for the past 40 years. It is the fastest way to

reconstruct an image, but has some distinct drawbacks. It isimpossible to incorporate accurate noise models or a prioriinformation about the image in the reconstruction process,and the mathematics become very difficult for non-standardgeometries. When considering microCT, the imaging scale getsmuch smaller and accurate noise modelling becomes moreimportant. Iterative techniques on the other hand do allowfor incorporating more accurate models, but due to the largedata sets and the fact that multiple reconstruction iterations areneeded, they can take days to converge to a solution. Due torecent improvements of general purpose Graphical ProcessingUnits (GPUs) however, it has become feasible to implementiterative algorithms on the GPU, effectively speeding them updue to parallelization. Hereafter we will introduce five iterativereconstruction algorithms for microCT, each one implementedon the GPU. We compared them to analytical reconstructionbased on noise, contrast, spatial resolution and reconstructiontimes. We also examined the influence of the start image onthese respective parameters.

II. METHODS

A. Hardware

All algorithms were implemented in NVidia R©CUDATM

, anAPI that allows general purpose programming for GPU. Tests

were performed on a NVidia TeslaTM

M2070-Q card. Thisis one of NVidias recent high-end GPUs, containing 448cores with 6GiB of onboard RAM memory. The host PC ranon an Intel R©Xeon R©E5620 quadcore processor and contained16GiB of RAM memory. Scans were made on a GM-I R©FLEXTriumph

TMscanner. This is a pre-clinical tri-modal scanner,

containing microCT, PET and SPECT subsystems.

B. Algorithms

The algorithms that were implemented are SART[1],OS-SART[2], OS-EM[3], OS-ISRA[4] and OS-MLTR[5]. Wechose to use the ordered subset extension of the algorithms,due to the limitations we faced concerning available memory.The full set of projections takes approximately 5GiB ofspace, which consumes most of the available memory on theGPU. Dividing the projections in subsets reduces this amountsignificantly, since only the projections in a subset need tobe loaded into the memory. Table I contains the number ofsubsets for each algorithm. We compared the normalized root-mean-square error (NRMSE) between subsequent iterationsfor different subset sizes. The lower the NRMSE betweeniterations, the further the algorithm has converged. For eachalgorithm we chose the number of subsets that let it convergefastest.

TABLE INUMBER OF SUBSETS PER ALGORITHM

SART OS-SART OS-EM OS-ISRA OS-MLTR

nr. subsets 1024 256 512 256 256

Equations 1-4 show the expressions for the differentalgorithms that were implemented – OS-SART and SARTshare the same equation since SART is a special case ofOS-SART. In the equations, the aij represent the coefficientsin the projection/backprojection matrix, xj the calculatedattenuation values, bi the log-adjusted measurements and yithe unadjusted measurements.

xn+1j = xnj +

1∑

i′∈Sn

ai′j

∑

i∈Sn

aij

bi −∑k

aikxnk

∑k

aik(1)

xn+1j =

xnj∑i′∈Sn

ai′j

∑

i∈Sn

aijbi∑

k

aikxnj(2)

2

xn+1j = xnj

∑i∈Sn

aijbi

∑i∈Sn

aij∑k

aikxnj(3)

xn+1j = xnj − 1

Dln

∑i∈Sn

aijyi

∑i∈Sn

aij yi

(4)

yi = bie−∑

k

aikxnk

The analytical reconstructions that were used as referencereconstruction, were reconstructed using the COBRA (ExximComputing Corporation, Pleasanton, Ca, USA) software pack-age, which implements a Feldkamp-type[6] analytical recon-struction algorithm for cone-beam geometries.

C. Phantoms

In order to be able to quantify the differences between thealgorithms, three phantoms were used. The first phantom isthe water phantom, consisting of a cylinder uniformly filledwith water, and is used to determine the noise propertiesof the algorithms. The second phantom we used was a lowcontrast phantom (QRM GmbH, Moehrendorf, Germany). Itis a cylindrical phantom with cylindrical inserts, which haveattenuation values that are 40 and 80 HU lower than theirsurroundings. It is used to determine the contrast resolutionof the different algorithms. The last phantom was a wirephantom (QRM GmbH, Moehrendorf, Germany). It is anairfilled, cylindrical phantom with two tungsten wires with10µm diameter, aligned parallel to the axial axis. One wire islocated in the center of the phantom, the other in the periphery,allowing the evaluation of the spatial resolution both in thecenter of the phantom and at the periphery.

D. Start Images

To evaluate the influence of the starting image, we discernedfour different starting images, of which three can be consideredlow-pass and one high-pass. The first start image is the moststraight-forward one. It is a uniform image, having only onesingle grey value (0 for the additive, 100 for multiplicativealgorithms). The second start image, the high-pass one, con-sists of random grey values (uniformly chosen in [0, 0.1[ forthe additive and in [1, 101[ for the multiplicative algorithms).As a third start image, we used the result of the analyticalreconstruction in an attempt to combine the benefits of bothanalytical and iterative reconstruction. The final start imagerepresents a similar attempt, however, instead of using theresult of an analytical reconstruction, we use the result of afast iterative reconstruction performed at a smaller resolution.

III. RESULTS

A. Noise

A random start image turns out to be a bad choice whennoise resistance is important. Using this start image, signal-to-noise ratios are only 30% of those obtained by using analytical

reconstruction. When using low-pass start images, OS-SARTand OS-MLTR introduce the least noise. Their signal-to-noise ratios are almost twice as high as those of SART, OS-EM and OS-ISRA reconstructions, and slightly higher thanthose of analytical reconstruction. When combined with themultiresolutional start image, OS-MLTR has a signal-to-noiseratio that is more than 50% higher than the signal-to-noiseratio of analytical reconstruction. The results of OS-MLTR incombination with this start image can be explained throughthe convergence speed of OS-MLTR. When determining theoptimal number of subsets, we saw that OS-MLTR convergesmuch slower than the other algorithms. Because of this, therewill be much less noise introduced after a first iteration. Sinceit is the first iteration that is upscaled and used as a start image,this results in a good signal-to-noise ratio.

B. Contrast

The results for optimal contrast are very much alike theresults of noise sensitivity. We didn’t consider the randomstart image when judging contrast, since the signal-to-noiseratios were so low that the cylindrical inserts couldn’t bediscerned on the scans. For the low-pass start images, themultiresolutional start image in combination with OS-MLTRagain produces the best results, with OS-SART as a closesecond. The contrast-to-noise ratio for this combination ismore than twice as high as the contrast-to-noise ratio ofanalytical reconstruction.

C. Spatial Resolution

For the spatial resolution, the starting image has less effecton the different results. Even for the random start image,similar results are obtained as for the other start images. Con-trary to the results for noise and contrast, the algorithms needmore time to achieve their best results for spatial resolution.This is normal, since the algorithms first reconstruct the low-pass part of the image, adding more detail as the number ofiterations rises. OS-ISRA has the highest spatial resolution.After 5 iterations the full width at half maximum (FWHM)of the center wire is about 0.16 mm, which is only slightlyhigher than analytical reconstruction, which has a FWHMof approximately 0.14 mm for the center wire. However,for the wire at the periphery, OS-ISRA has a FWHM ofapproximately 0.16 mm, opposed to 0.21 mm for analyticalreconstruction. OS-SART and OS-MLTR, the algorithms thatscored best at noise sensitivity and contrast resolution, havethe lowest spatial resolution, with a FWHM of 0.23 to 0.25mm for both wires. OS-ISRA however introduced significantlymore noise in its reconstruction than OS-SART, OS-MLTRand analytical reconstruction. So even though their spatialresolution is higher, the reconstructions produced by OS-SART, OS-MLTR and especially analytical reconstruction willbe visually better.

D. Execution Time

The two fastest algorithms of the five we tested, were OS-ISRA and OS-MLTR. Their execution times were several min-utes faster than those of the other algorithms, when iterating

3

for maximal noise resistance and contrast. The execution timesare however still a lot higher than those of analytical recon-struction – typically twice as high – but they aren’t unfeasibleanymore. The largest contributing factor to the execution timeis the backprojection step in the algorithms, taking up almost85% of the execution times. The implementations of bothOS-ISRA and OS-MLTR also have some more room for im-provement, since each iteration has two backprojections – thedirect consequence of doing the calculations in image space.Because we divided the projections in subsets, each subsethas to be backprojected. If more memory is available, or lessprojections are used, the backprojections can be precalculated,further reducing the execution times.

IV. CONCLUSION

We have been able to show that, especially for noiseand contrast, superior results can be obtained by iterativereconstruction, compared to analytical construction. Executingthe algorithms on GPU is still slower than analytical recon-struction, but the execution times are no longer unfeasiblyhigh. It can thus be concluded that, in the years to come, iter-ative reconstruction will be a viable alternative for analyticalreconstruction in pre-clinical practice.

REFERENCES

[1] A. H. Andersen and A. C. Kak, “Simultaneous algebraic reconstructiontechnique (SART): a superior implementation of the art algorithm,”Ultrasonic Imaging, vol. 6, no. 1, pp. 81–94, 1984.

[2] G. Wang and M. Jiang, “Ordered-Subset Simultaneous Algebraic Re-construction Techniques (OS-SART),” Journal of X-Ray Science andTechnology, vol. 12, no. 3, pp. 167–177, 2004.

[3] M. Hudson and R. Larkin, “Accelerated Image Reconstruction usingOrdered Subsets of Projection Data,” IEEE Trans. Med. Imag, vol. 13,pp. 601–609, 1994.

[4] M. E. Daube-Witherspoon and G. Muehllehner, “An Iterative ImageSpace Reconstruction Algorthm Suitable for Volume ECT,” IEEE Trans.Med. Imag, vol. 5, pp. 61–66, june 1986.

[5] J. Nuyts, B. De Man, P. Dupont, M. Defrise, P. Suetens, and L. Mortel-mans, “Iterative reconstruction for helical CT: a simulation study,”Physics in Medicine and Biology, vol. 43, no. 4, pp. 729–737, 1998.

[6] L. A. Feldkamp, L. C. Davis, and J. W. Kress, “Practical cone-beamalgorithm,” J. Opt. Soc. Am. A, vol. 1, pp. 612–619, June 1984.

Lijst van symbolen en afkortingen

ART Algebraic Reconstruction Technique

CNR Contrast-to-Noise Ratio

CT Computed Tomography

CUDA Compute Unified Device Architecture

EM Expectation Maximisation

FBP Filtered Backprojection

FWHM Full Width at Half Maximum

GPU Graphical Processing Unit

GPGPU General Purpose Graphical Processing Unit

HU Hounsfield Unit

ISRA Image Space Reconstruction Algorithm

ML-EM Maximum Likelihood Expectation Maximisation

MLTR Maximum Likelihood algorithm for Transmission tomography

NRMSE Normalised Root Mean Square Error

OS-EM Ordered Subset Expectation Maximisation

OS-SART Ordered Subset Simultaneous Algebraic Reconstruction Technique

PET Positron Emission Tomography

PSF Point Spread Function

SART Simultaneous Algebraic Reconstruction Technique

SNR Signal-to-Noise Ratio

SPECT Single Photon Emission Computed Tomography

x

Inhoudsopgave

Voorwoord v

Overzicht vi

Extended Abstract vii

Lijst van symbolen en afkortingen x

Inhoudsopgave xi

1 Inleiding 1

1.1 CT . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1

1.1.1 Achtergrond . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1

1.1.2 Acquisitie . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1

1.1.3 CT-beeld . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 3

1.2 Micro-CT . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 4

1.3 Reconstructie . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 5

1.3.1 Analytische Reconstructie . . . . . . . . . . . . . . . . . . . . . . . . . . . 6

1.3.2 Iteratieve Reconstructie . . . . . . . . . . . . . . . . . . . . . . . . . . . . 8

1.4 Doel van thesis . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 10

2 Methodieken 12

2.1 Opstelling . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 12

2.2 Algoritmes . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 12

2.2.1 OS-SART en SART . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 13

2.2.2 OS-EM . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 15

2.2.3 OS-ISRA . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 16

2.2.4 OS-MLTR . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 17

2.3 Fantomen en metrieken . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 18

2.3.1 Ruis en Contrast . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 18

2.3.2 Resolutie . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 19

2.4 Invloed van het startbeeld . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 19

2.5 Monte Carlo Simulatie . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 22

xi

Inhoudsopgave xii

3 Resultaten 23

3.1 Convergentie . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 23

3.2 Ruisgevoeligheid . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 25

3.3 Contrast . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 33

3.4 Resolutie . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 38

3.5 Snelheid . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 47

3.5.1 Vergelijking van de uitvoeringstijden . . . . . . . . . . . . . . . . . . . . . 47

3.5.2 Analyse van de uitvoeringstijden . . . . . . . . . . . . . . . . . . . . . . . 47

4 Conclusie 52

4.1 Bespreking van de algoritmes . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 52

4.2 Eindbeschouwing . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 53

Bibliografie 55

Hoofdstuk 1

Inleiding

1.1 CT

CT – Computed Tomography – is een veelgebruikte niet-invasieve techniek in de medische beeld-

vorming. Deze wordt gebruikt voor het genereren van 3D beelden van de binnenkant van een

object. De techniek maakt gebruik van tomografie om, op basis van een groot aantal traditionele

rontgenfoto’s onder verschillende hoeken, een reeks axiale doorsneden van het object te creeren.

1.1.1 Achtergrond

De basis voor CT werd voor het eerst gelegd door Johann Radon in 1917 [1][2], toen hij bewees

dat het, gegeven genoeg lijnintegralen doorheen een oppervlak, mogelijk is om de verdeling van

deze waarden over datzelfde oppervlak te berekenen. De bevindingen van Radon werden echter

niet meteen opgepikt voor medische toepassingen. Het duurde tot de jaren 60 van vorige eeuw

voordat hierin verandering kwam. Aangezien traditionele radiografie inherent slechts beperkte

informatie kan weergeven, werd gezocht naar nieuwe alternatieven. Een rontgenfoto is immers

een superpositie van alle weefsels waar de x-stralen doorheen zijn gegaan, en dus is het zeer

moeilijk om diepte-informatie te verkrijgen. In de jaren 60 kwam men tot de conclusie dat

een rontgenfoto in principe zeer goed te vergelijken valt met een set lijnintegralen doorheen het

object. Het moest dus mogelijk zijn om met behulp van voldoende foto’s een accuraat beeld

te krijgen van de binnenkant van een object. Het duurde tenslotte nog tot de jaren 70 – en de

opkomst van de eerste relatief compacte computers – vooraleer een praktische implementatie

ontwikkeld werd door Hounsfield.

1.1.2 Acquisitie

CT maakt gebruik van rontgenfoto’s voor het afbeelden van de binnenkant van een object. Het

proces waarbij op basis van deze rontgenfoto’s een 3D beeld wordt gemaakt, heet reconstructie

(zie 1.3). Vooraleer met reconstructie kan begonnen worden, zijn er dus eerst rontgenfoto’s no-

dig. Rontgenstralen hebben de eigenschap dat ze, wanneer ze door een object gaan, geabsorbeerd

worden. Dit fenomeen wordt attenuatie genoemd. De mate waarin de rontgenstraal geattenu-

eerd wordt, hangt af van de attenuatiecoefficient en de dikte van het object waar ze doorheen

gaat. Als I0 de intensiteit is van de uitgezonden rontgenstraal, µ de attenuatiecoefficient en d

1

Hoofdstuk 1. Inleiding 2

de lengte van het pad van de straal doorheen het object, dan wordt de uiteindelijke intensiteit

I gegeven door 1.1. Wanneer het een heterogeen object betreft, kan deze formule eenvoudig

uitgebreid worden naar 1.2 wanneer de overgang tussen de verschillende materialen discreet is,

of naar 1.3 wanneer de overgang tussen de materialen continu is.

I = I0e−µd (1.1)

I = I0e−

∑iµidi

(1.2)

I = I0e−

∫L

µ(r)ds

(1.3)

De mate waarin de fotonen in de rontgenstraling geabsorbeerd worden door het weefsel, hangt

echter ook af van hun energie. Dit betekent dat formule 1.3, die enkel rekening houdt met de

positie r(x,y,z), nog aangepast moet worden om dit effect in rekening te brengen. Formule 1.4

geeft de correcte uitdrukking, waarbij eveneens rekening gehouden wordt met het energiespec-

trum. Deze formule wordt ook de wet van Beer-Lambert genoemd[3][4]. Wanneer geen rekening

gehouden wordt met het energiespectrum van de rontgenstralen, kunnen artefacten in het beeld

optreden.

Fotonen met een lage energie worden veel sneller geabsorbeerd door weefsel dan fotonen met

hoge energie[5][6], een effect dat beam-hardening wordt genoemd1. Dit vertaalt zich in een

beeld dat in het midden donkerder zal zijn dan aan de zijkanten. Het is dus belangrijk om de

rontgenstralen op voorhand reeds te filteren, zodat enkel de rontgenstralen met hogere energie

door het weefsel gaan. Alle lage-energie rontgenstralen die uitgestuurd en volledig geabsorbeerd

worden, leveren immers geen enkele informatie op voor de beeldvorming, maar zorgen er echter

wel voor dat de patient nodeloos een hogere dosis straling binnenkrijgt.

I =

∫I0(E)e

−∫L

µ(E,r)ds

dE (1.4)

Om een zinvolle reconstructie te kunnen uitvoeren, zijn er vele projecties nodig vanuit ver-

schillende hoeken. Doorgaans worden de stralingsbron en de detector aan weerszijden van een

roterende gantry gemonteerd, met het te scannen object in het middelpunt. Op die manier kan

het te scannen object – bv. een patient – stationair blijven, terwijl de bron en de detector er

omheen draaien.

Figuur 1.1 geeft een schematische voorstelling van een mogelijke opstelling, waarbij per rotatie

van de bron en detector, een enkele slice gescand wordt. Deze figuur is een voorbeeld van een

fan-beam systeem; de rontgenstralen hebben een waaiervorm en de detector is slechts 1 pixel

breed. In de x- en y-richting valt het object volledig binnen de stralenbundel, dus er is enkel

een axiale translatie nodig om een volledig object te kunnen scannen. Hierbij kan er ofwel een

1Een rontgenstraal met breed energiespectrum wordt uitgestuurd, maar enkel het hoog-energiegedeelte wordt

gedetecteerd; de straal is ‘harder’ geworden.

Hoofdstuk 1. Inleiding 3

continue ofwel sequentiele translatie gebruikt worden. Bij de eerste zal de bron een spiraalvormig

pad vormen rond het object, bij de tweede is er telkens een afwisseling van een volledige rotatie

en een kleine translatie.

Figuur 1.1: Schematische voorstelling van een CT-scanner

Een tweede soort systeem – hetwelke in dit werk gehanteerd zal worden – is een cone-beam

scanner. Hierbij heeft de bundel rontgenstralen de vorm van een kegel en is de detector een

vlakke rechthoek – hetgeen dus betekent dat slechts een piramidevormig gebied gedetecteerd

wordt. Door deze geometrie zal een groter deel van het object per rotatie gescand kunnen

worden, waardoor er minder rotaties nodig zijn. Bij micro-CT zal het volledige object zelfs

binnen de stralenbundel vallen, waardoor slechts een rotatie nodig is om het volledige object te

kunnen reconstrueren. Door gebruik te maken van een cone-beam wordt het reconstrueren wel

moeilijker, aangezien er nu 3D reconstructie nodig is, waar het bij fan-beam systemen voldoende

was om 2D reconstructies te doen.

1.1.3 CT-beeld

Een CT-beeld bestaat uit een hele reeks 2D beelden, die elk een axiale doorsnede van het

gescande object voorstellen. Aangezien elk van deze doorsneden een bepaalde dikte heeft, zullen

de pixels in deze 2D beelden in principe kleine volume-elementjes voorstellen. Omwille hiervan

wordt bij CT-beelden nooit de term pixel gebruikt, maar veeleer de term voxel – volume element.

Elke voxelwaarde is een maat voor de attenuatie van het volume-element dat de voxel voorstelt.

Aangezien de gemeten waarden echter ook afhankelijk zijn van de energie van de rontgenstralen,

zullen de voxelwaarden slechts een relatieve maat zijn voor de attenuatie. De voxelwaarden

voor een bepaald soort materiaal kunnen dus varieren over verschillende scans. Het is echter

wel zo dat de onderlinge verhoudingen van de voxelwaarden van verschillende materialen binnen

een scan dezelfde zullen zijn in andere scans. Het is dus mogelijk om de voxelwaarden te

normaliseren, zodat een kwantitatieve vergelijking van scans mogelijk is. Om voxelwaarden te

Hoofdstuk 1. Inleiding 4

normaliseren wordt gebruik gemaakt van formule 1.5. Deze formule toont hoe voxelwaarden

kunnen omgezet worden naar Hounsfield Units (HU). De Hounsfield schaal – genoemd naar Sir

Godfrey Newbold Hounsfield1 – neemt de attenuatiecoefficient van water als het referentiepunt

ten opzichte waarvan de voxelwaarden geschaald worden. Volgens deze formule zal water dus

een voxelwaarde van 0 krijgen. Aangezien de attenuatiecoefficient van water gebruikt wordt als

callibratiepunt, zal het dus nodig zijn om een waterfantoom te scannen, teneinde de voxelwaarden

van andere scans te kunnen schalen.

HU = 1000 ∗ µ(x, y, z)− µwaterµwater

(1.5)

1.2 Micro-CT

Terwijl CT beeldvorming al verscheidene decennia een veelgebruikte beeldvormingstechniek is,

heeft het toch relatief lang geduurd vooraleer deze ook ingang vond in laboratoriumomstandig-

heden en pre-klinische tests. De belangrijkste reden hiervoor is de beperkte spatiale resolutie

van een CT-scanner. In pre-klinische omstandigheden zijn knaagdieren nog steeds de de facto

standaard waar het het testen van geneesmiddelen en therapieen betreft. De grootte van een

voxel in een klinische CT scanner ligt ergens rond de 0.35 mm3, hetgeen voldoende detail weer-

geeft wanneer het om mensen gaat. Wanneer echter wordt overgegaan op knaagdieren, komt

deze 0.35 mm3 anatomisch gezien overeen met een voxelgrootte van ongeveer 17 µm3[7]. Hieruit

ontstond dus de nood voor micro-CT; CT-scanners met een spatiale resolutie die veel hoger ligt

dan deze die normaal bereikt kan worden met klinische CT scanners.

Er gingen verscheidene uitdagingen gepaard met het ontwerpen van de eerste micro-CT scanners.

Het is bijvoorbeeld veel moeilijker om een roterende gantry te stabiliseren voor een micro-

CT scanner, dan voor een klinische CT scanner, aangezien de schaal veel kleiner is[8]. De

eerste systemen die ontwikkeld werden waren dan ook de micro-CT scanners waarbij de bron en

detector stationair kunnen blijven. Dit heeft uiteraard als gevolg dat het specimen moet roteren.

Aangezien dit praktische problemen geeft voor in vivo micro-CT – waarbij het specimen nog in

leven is2 – worden dit soort systemen voornamelijk gebruikt bij in vitro beeldvorming. Pas later

werden dan de eerste systemen geıntroduceerd waarbij het specimen stationair kon blijven en

de rontgenbron en detector roteren. Dit zijn dan effectief schaalmodellen van de klinische CT

scanners.

Verder zal ook de ruis een groot probleem vormen bij microCT. Formule 1.6 3 geeft de vari-

antie van de lineaire attenuatie coefficient – en dus een maat voor de ruis – in functie van een

aantal parameters. σ2sys is een term die staat voor alle ruis die geproduceerd wordt door foton-

onafhankelijke bronnen4. Verder staat ∆x voor de voxelgrootte in de reconstructie afbeelding,

nang voor het aantal projecties dat gebruikt wordt om deze afbeelding te bekomen en N voor het

1Als eerbetoon voor het maken van de eerste praktische CT-scanner.2Door een levend specimen te laten roteren wordt de beeldvorming beınvloed; ingewanden zullen zich verplaat-

sen tijdens het roteren, waardoor artefacten zullen ontstaan.3Formule overgenomen uit [9]4e.g. ruis die geıntroduceerd wordt door de detector

Hoofdstuk 1. Inleiding 5

aantal fotonen per geprojecteerde lijnintegraal. Ruis is dus omgekeerd evenredig met de voxel-

grootte, hetgeen betekent dat de grotere spatiale resolutie van microCT extra ruis introduceert

ten opzichte van klinische CT. Het aantal voxels, L in formule 1.7, is dan weer evenredig met

de ruis. Meer voxels zullen dus ook meer ruis introduceren. Voorts staat ook N in de noemer

van formule 1.6, met andere woorden, hoe minder fotonen ontvangen worden, hoe meer ruis de

gereconstrueerde afbeelding zal bevatten. Het aantal fotonen dat ontvangen wordt, is, zoals for-

mule 1.7 aangeeft, afhankelijk van een aantal parameters. Enerszijds is er het aantal fotonen dat

vertrekt uit de bron. Dit wordt bepaald door de hoeveelheid fotonen geproduceerd per eenheid

van stroomsterkte (φ), de stroomsterkte van de bron (I) en de duur van de blootstelling (∆t).

Hoe meer fotonen vertrekken vanuit de bron, hoe meer er ook kunnen aankomen. Voorts speelt

ook de grootte (W en H), het aantal (n) en de efficientie (η) van de detector-elementen een rol.

Grotere detector-elementen kunnen meer fotonen ontvangen en deze zullen dan ook minder ruis

introduceren. Bij microCT zijn de detector-elementen echter een heel stuk kleiner dan bij CT

het geval is, aangezien op een kleinere schaal gewerkt wordt. Dit zal er dus opnieuw voor zorgen

dat microCT beelden ruiziger zijn dan CT beelden.

σ2µ =π2

12∆x2nangN+ σ2sys (1.6)

N =φI∆tnWHηe−µd

L(1.7)

Tenslotte zorgt ook de dosis rontgenstraling die gebruikt kan worden voor in vivo acquisitie

voor problemen. De hoeveelheid straling die een mens kan verdragen zonder negatieve effecten

te ondervinden, is vele malen groter dan deze die de proefdieren die in pre-klinische testen

gebruikt worden kunnen verdragen. In het bijzonder wanneer het over studies gaat waarbij

eenzelfde dier vele malen gescand dient te worden, moet de dosis zeer laag gehouden worden[9].

De dosis laag houden betekent de energie van de fotonen verhogen, waardoor er minder fotonen

geabsorbeerd zullen worden. Dit zal er eveneens voor zorgen dat er meer fotonen gedetecteerd

zullen worden (e−µd in 1.7) en er dus minder ruis aanwezig zal zijn. Wanneer er echter minder

fotonen geabsorbeerd worden, zal de beeldvorming verstoord worden. Het is immers net de

absorptie van fotonen die voor een beeld zorgt. Er zal dus nauwkeurig een dosis gekozen moeten

worden die te verdragen is door de proefdieren, maar toch nog een kwalitatief beeld geeft.

1.3 Reconstructie

Het omzetten van projecties naar de eigenlijke 3D beelden kan op verschillende manieren ge-

beuren. Deze reconstructietechnieken kunnen in twee grote categorieen onderverdeeld worden,

afhankelijk van de manier waarop de reconstructie gedaan wordt. Enerzijds zijn er de analyti-

sche reconstructietechnieken, die traditioneel het meest gebruikt worden voor het reconstrueren

van CT-beelden en anderzijds zijn er de iteratieve technieken, die vooral bij SPECT en PET

gangbaar zijn, maar de laatste jaren ook hun opmars maken bij de reconstructie van CT-beelden.

In wat volgt zullen beide categorieen aan bod komen, met elk hun voor en nadelen.

Hoofdstuk 1. Inleiding 6

1.3.1 Analytische Reconstructie

Principe1

Zoals in 1.1.1 reeds kort vermeld werd, kan de waarde die een detector meet wanneer er een

rontgenstraal op invalt, vergeleken worden met het nemen van een lijnintegraal over de attenu-

atiewaarden langs het pad van deze rontgenstraal. Radon bewees reeds in 1917[1] dat het op

basis van voldoende lijnintegralen onder verschillende hoeken, het mogelijk is om het geprojec-

teerde object te reconstrueren. Hoe dit in zijn werk gaat kan het eenvoudigst begrepen worden

wanneer overgegaan wordt op een systeem waarbij de acquisitie gebeurt via een reeks parallelle

rontgenstralen die door een 2D object gaan. Een projectie van een CT-scanner onder de projec-

tiehoek θ kan dan vergeleken worden met het nemen van een reeks lijnintegralen over het object,

vooropgesteld dat er een kleine aanpassing wordt gedaan aan de projectiedata. Formule 1.4 in

1.1.2 gaf de uitdrukking voor de gemeten intensiteiten. Door abstractie te maken van de energie-

afhankelijkheid, kan deze uitdrukking omgevormd worden tot 1.8, hetgeen een lijnintegraal over

de attenuatiecoefficienten voorstelt.

ln

(I

I0

)=

∫

L

µ(r)ds (1.8)

x cosθ + y sinθ = t (1.9)

pθ(t) =

∫ ∫f(x, y) δ(x cosθ + y sinθ − t)dx dy (1.10)

Laat 1.9 de formule zijn voor een lijn onder een hoek θ door het punt (0, t), dan zal de Radon

transformatie van het object waarvan de attenuatiewaarden verdeeld zijn volgens f(x, y) gegeven

worden door 1.10. Het doel van analytische reconstructie is om op basis van deze projecties pθ(t)

het geprojecteerde object te reconstrueren. De eenvoudigste manier om van deze projecties terug

te gaan naar het geprojecteerde beeld, is door de projectieoperatie te inverteren. Formule 1.11

toont zo een backprojectie, waarbij de projectiewaarden uniform uitgesmeerd worden langs het

pad van de lijnintegraal. Door dit te doen voor alle projecties – zoals in 1.12 – kan dan een

gereconstrueerd beeld bekomen worden. Bemerk ook dat de grenzen van de integraal slechts

lopen van 0 tot π. Dit betekent dus dat het voldoende is om over een hoek van 180◦ projecties

te nemen om een volledig beeld te bekomen.

bθ(x, y) =

∞∫

−∞

pθ(t) δ(x cosθ + y sinθ − t)dt (1.11)

fb(x, y) =

π∫

0

bθ(x, y)dθ (1.12)

De backprojectie in 1.12 heeft echter een groot probleem. Aangezien er geen a priori informatie is

over de te reconstrueren afbeelding, werd ervoor gekozen om de projecties uniform uit te smeren

1Op basis van [10]

Hoofdstuk 1. Inleiding 7

over de projectielijn. Dit zorgt er weliswaar voor dat een punt met een hoge attenuatiewaarde

ook effectief een hoge voxelwaarde zal krijgen, maar dit zorgt er ook voor dat, juist door het

uitsmeren, de omgeving van dit punt ook een hogere waarde zal krijgen. Figuur 1.2 toont dit

fenomeen wanneer een puntbron eerst geprojecteerd en vervolgens teruggeprojecteerd wordt. Het

rechter gedeelte van de figuur illustreert het resultaat dat idealiter bekomen zou moeten worden

na de reconstructie; een wit punt met een scherpe aflijning ten opzichte van zijn omgeving.

Hetgeen echter bekomen wordt na een backprojectie is het linker deel van de figuur; een wit punt

dat uitgesmeerd is over zijn omgeving. Het spreekt voor zich dat hoe meer projecties gebruikt

zullen worden, hoe minder opvallend dit uitsmeren zal zijn. Een groot aantal projecties gebruiken

zal echter geen perfecte oplossing zijn, aangezien er steeds een wazige rand zal overblijven.

Figuur 1.2: Het verschil tussen het bekomen en het gewenste resultaat voor backprojectie

Een betere oplossing kan gevonden worden door figuur 1.2 nogmaals te bekijken. Het linker deel

stelt het resultaat voor van het projecteren en terugprojecteren van een puntbron. Dit deel van

de figuur kan dus beschouwd worden als het impulsantwoord van het systeem. Er kan aangetoond

worden dat dit impulsantwoord gegeven wordt door 1r , waardoor de backprojectie kan beschouwd

worden als het originele beeld geconvolueerd met dit impulsantwoord. De meest voor de hand

liggende oplossing is dan om de backprojectie te gaan Fourier-transformeren om deze factor te

verwijderen. Een 2D Fourier-transformatie is echter enorm traag, daar waar de backprojectie

zeer snel is. Het centrale sectie theorema stelt echter dat de 1D Fourier-transformatie van

de projectie van een 2D functie, equivalent is met de lijn die onder de projectiehoek door

het centrum van de 2D Fourier-transformatie van deze 2D functie gaat. Anders gezegd, een

trage 2D Fourier-transformatie kan omzeild worden door een snelle 1D Fourier-transformatie

van de projecties. Met 1.13 en 1.14 als de Fourier-transformatie en diens inverse, kan dus een

gefilterde vorm van de backprojectie1 opgesteld worden. Formule 1.15 toont hoe in FBP elke

projectie gecorrigeerd kan worden met een ramp filter – het Fourier-spectrum equivalent van het

impulsantwoord – alvorens de backprojectie uit te voeren. Deze correctie zal negatieve waarden

1FBP oftewel Filtered Backprojection

Hoofdstuk 1. Inleiding 8

introduceren, die er dan voor zullen zorgen dat het uitsmeren verdwijnt.

F1(pθ(t) =

∫pθ(t) e

−j2πρtdt (1.13)

pθ(t) =

∫F1(pθ(t)) e

j2πρtdρ (1.14)

f(x, y) =

π∫

0

∞∫

−∞

F1(pθ(t)) ej2πρt |ρ|dρ

δ(x cosθ + y sinθ − t)dθ (1.15)

Zoals al eerder werd vermeld, zal in dit werk echter gebruik gemaakt worden van een cone-beam

scanner. Formule 1.15 zal dus niet in deze vorm gebruikt worden, al zal hetzelfde principe

wel blijven gelden. In plaats van 1.15 zal het FDK [11] algoritme voor cone-beam geometrieen

gebruikt worden, in combinatie met Parker Weighting[12].

Nadelen

Filtered Backprojectie mag dan al zeer snel zijn – de voornaamste reden voor zijn populariteit

– het heeft echter ook een aantal nadelen. Allereerst veronderstelt FBP exacte projectiedata.

Dit is echter een utopie, aangezien er uit 1.6 al bleek dat er redelijk wat ruis op de gemeten

data kan zitten. Voorts zal het filteren van de projectiedata met een ramp filter enkel werken

wanneer er een voldoende groot aantal projecties zal zijn. Indien dit niet het geval is, zullen er

streepartefacten ontstaan. Tot slot is het ook volkomen onmogelijk om enige a-priori informatie

over de ruis of over het te reconstrueren beeld te incorporeren in de reconstructie, hetgeen wel

perfect mogelijk zal zijn bij iteratieve reconstructie.

1.3.2 Iteratieve Reconstructie

Principe

Iteratieve reconstructie start vanuit een andere premisse dan analytische reconstructie. In plaats

van uit te gaan van een Radon model, wordt bij iteratieve reconstructie gekozen voor een alge-

mener lineair model. Op deze manier wordt het mogelijk om meer informatie over het acquisitie-

proces en de aard van het beeld te incorporeren in de reconstructie [13]. Dit heeft uiteraard als

gevolg dat het beeld dat bekomen wordt door iteratieve reconstructie een stuk nauwkeuriger zal

zijn dan datgene dat bekomen wordt door analytische reconstructie. Door een betere modellering

van de ruis zal deze bijvoorbeeld een stuk minder aanwezig zijn bij iteratieve reconstructies.

Iteratieve reconstructie algoritmes benaderen het probleem van de reconstructie steeds op de-

zelfde manier.

Gegeven een set gemeten projectiewaarden en extra informatie over de metingen, de

afbeelding en het gescande object, zoek de distributie van de attenuatiewaarden in

het object.

Dit komt overeen met een algemeen lineair inverse probleem. Uiteraard is het in het geval

van CT niet praktisch om in het continue domein te werken, dus wordt er in het discrete

domein gewerkt. De structuur van iteratieve algoritmes is over het algemeen vrij gelijkaardig,

Hoofdstuk 1. Inleiding 9

Figuur 1.3: Iteratieve reconstructie

op een paar kleine variaties na. Er zijn steeds vier duidelijke stappen te onderscheiden in elke

iteratie: een projectie, het berekenen van de fout, een terugprojectie en een update van de

reconstructie. Een algemeen schema is gegeven in Figuur 1.3. Er wordt gestart van een zeker

startbeeld1, hetgeen geprojecteerd wordt om een reeks projecties te bekomen. Deze projecties

worden dan vergeleken met de projecties die bekomen zijn via metingen. De fout die hieruit

bekomen wordt, wordt teruggeprojecteerd naar de afbeeldingsruimte, om vervolgens gebruikt te

worden in de update van het startbeeld. Dit nieuwe beeld wordt daarna gebruikt als startbeeld

van de volgende iteratie. Op deze manier zal het beeld stap voor stap dichter bij de oplossing

van het reconstructie-probleem komen. De exacte vorm van het schema in Figuur 1.3 hangt

voornamelijk af van de optimalisatiefunctie. Afhankelijk van de functie die bepaalt hoe dicht

een bepaald beeld komt bij het beoogde resultaat, zal het schema een andere implementatie

krijgen.

Iteratieve reconstructietechnieken werden tot nu toe voornamelijk gebruikt bij nucleaire beeld-

vormingstechnieken, zoals PET2 en SPECT3. Bij deze beeldvormingstechnieken is een Radon-

model een slechte benadering van de acquisitie, waardoor analytische reconstructie zeer moeilijk

is. Iteratieve reconstructietechnieken geven veruit de beste resultaten waardoor deze dan ook

al vele jaren in gebruik zijn. Het voordeel is dat de algoritmes die in PET en SPECT gebruikt

worden voor iteratieve reconstructie, op een paar wijzigingen na, ook gebruikt kunnen worden

voor CT reconstructie. Veel van de algoritmes die gebruikt worden voor iteratieve reconstructie

bij CT zijn dus al vele jaren in gebruik bij iteratieve reconstructie voor PET en SPECT.

Limitaties

De keuze tussen iteratieve en analytische reconstructie is er voornamelijk een tussen nauwkeu-

righeid en efficientie. Iteratieve reconstructie zal een nauwkeuriger beeld geven dan analytische

reconstructie, aangezien de werkelijkheid nauwkeuriger gemodelleerd kan worden. Aan de andere

1Meer informatie hieromtrent in 2.42Positron Emission Tomography3Single-Photon Emission Computed Tomography

Hoofdstuk 1. Inleiding 10

kant zal iteratieve reconstructie een stuk langer duren dan analytische. Dit is eenvoudig te zien

in Figuur 1.3. Waar bij analytische reconstructie enkel een terugwaartse projectie uitgevoerd

moet worden, moet bij iteratieve reconstructie bij elke iteratie zowel een voorwaartse als een

terugwaartse projectie uitgevoerd worden. Dit zorgt er uiteraard voor dat de uitvoeringstijden

bij iteratieve reconstructie een tot meerdere grootteorden hoger liggen dan bij analytische re-

constructie. Rekentijden die uren tot dagen aanslepen zijn niet ongewoon, en het behoeft weinig

illustratie dat dit een van de redenen is waarom het gebruik van iteratieve reconstructietechnie-

ken vooral beperkt blijft tot laboratorium-omstandigheden.

Een tweede beperking van iteratieve reconstructie is de hoeveelheid geheugen die nodig is voor

de reconstructie. Tabellen 1.1 en 1.2 geven een indicatie van de hoeveelheid geheugen die nodig

is om de projecties en de reconstructie bij te houden. Terwijl de grootte van de afbeelding

enigszins beperkt blijft, loopt de benodigde hoeveelheid geheugen voor de projecties al snel op

tot enkele gigabytes. Deze hoeveelheid wordt nog eens verdubbeld wanneer de fout met de

gemeten projecties berekend wordt, aangezien dan zowel de berekende als de gemeten projecties

in het geheugen moeten gehouden worden. Dit is nog een reden waarom iteratieve reconstructie

– tot voor enkele jaren – nooit echt ingang vond bij CT. Het is pas sinds eind twintigste,

begin eenentwintigste eeuw dat computers over voldoende werkgeheugen beschikken om deze

hoeveelheden data te kunnen bevatten.

#projecties 256 512 1024

Grootte (GiB) 1.26 2.53 5.06

Tabel 1.1: Benodigd geheugen voor pro-

jecties

#pixels 2563 5123

Grootte (MiB) 64 512

Tabel 1.2: Benodigd geheugen voor ge-

reconstrueerd beeld

1.4 Doel van thesis

In dit werk zal gepoogd worden om een oplossing te vinden voor de extreem hoge reconstructie-

tijden die bij iteratieve reconstructie gangbaar zijn. Zoals zal blijken in 2.2 zijn de algoritmes

die gebruikt worden voor iteratieve reconstructie voor een groot deel parallelliseerbaar. Dit

biedt dus een groot potentieel voor het verlagen van de uitvoeringstijd. In de voorbije jaren

werd het steeds interessanter om oplossingsmethoden te parallelliseren met behulp van de GPU1

[14][15]. Deze hardware is specifiek ontworpen om op zeer efficiente manier extreem parallelle

programma’s uit te voeren. Traditioneel zijn deze volledig geoptimaliseerd voor grafische toe-

passingen – vandaar ook de naam – aangezien deze bijna uitsluitend gebruikt werden door de

game-industrie. Meer recent echter zijn de API’s aangepast om meer algemene berekeningen te

kunnen ondersteunen, waardoor de GPU’s zijn geevolueerd naar GPGPU’s2. Onder meer de

NVidia® CUDA� API [16] biedt de mogelijkheid om NVidia’s grafische kaarten te gebruiken

voor meer algemene doeleinden.

1Graphical Processing Unit, de grafische kaart van de PC2General Purpose GPU

Hoofdstuk 1. Inleiding 11

Verderop zullen vijf algoritmes geıntroduceerd worden die in dit werk aan bod zullen komen. Elk

van deze algoritmes zal geımplementeerd worden voor GPU. Op deze manier zullen de extreem

lange uitvoeringstijden, die kenmerkend zijn voor iteratieve reconstructie, vermeden kunnen

worden. De algoritmes zullen onderling vergeleken worden op basis van een aantal metrieken1

en voor elke metriek zal ook telkens de vergelijking gemaakt worden met een beeld dat bekomen

werd via analytische reconstructie. Op deze manier zal het mogelijk zijn om de performantie

van elk algoritme te beoordelen in functie van de omgevingsparameters. Zo zal dan uiteindelijk

blijken of het mogelijk is om via iteratieve reconstructie resultaten te verkrijgen die beter zijn

dan deze bekomen via analytische reconstructie, in vergelijkbare uitvoeringstijden.

1zie hoofdstuk 2

Hoofdstuk 2

Methodieken

2.1 Opstelling

Alle testen werden uitgevoerd op de PC waarvan de specificaties weergegeven worden in tabellen

2.1 en 2.2. Het framework van de algoritmes bouwde voort op het framework dat eerder al

gecreeerd werd door Bert Vandeghinste, geschreven in C++. De algoritmes zelf werden voor

het grootste deel uitgevoerd op de GPU; de code hiervoor werd geschreven in CUDA�.

NVidia®Tesla�M2070-Q

Aantal CUDA�cores 448

Geheugen 6 GiB

Enkele-precisie 1030 GFLOP

Dubbele-precisie 515 GFLOP

API CUDA�

Tabel 2.1: Specificaties van de grafische

kaart

Host

CPU Intel®Xeon®E5620

Kloksnelheid 2.40GHz

#Cores 4 (8 Threads)

Geheugen 16 GiB

OS Fedora 13

Tabel 2.2: Specificaties van

de host PC

Voor het scannen van fantomen werd gebruikt gemaakt van een FLEX Triumph�(Gamma Me-

dica Ideas, Northridge, CA, USA) scanner. Dit is een pre-klinische, tri-modale scanner die over

zowel een micro-CT als een PET en SPECT scanner beschikt. In dit werk werd uiteraard enkel

de CT modaliteit gebruikt. Tenslotte werden de analytische reconstructies uitgevoerd met be-

hulp van het COBRA softwarepakket van Exxim Computing Corporation, dat, zoals eerder al

vermeld werd, een Feldkamp-type reconstructie implementeert.

2.2 Algoritmes

In dit werk zullen vijf algoritmes onderzocht worden: OS-SART, SART, ISRA, MLEM en MLTR.

Door de limitaties die in 1.3.2 en 1.4 aan bod gekomen zijn, zullen er echter enkele aanpassingen

moeten aangebracht worden aan deze algoritmes. Algoritmes zoals ISRA, MLEM en MLTR heb-

ben immers meer geheugen nodig dan er beschikbaar is op de GPU, aangezien zij alle projecties

in het geheugen houden. Deze beperking kan eenvoudig omzeild worden door voor elk van deze

algoritmes een ordered subset[17] versie te maken. Dit houdt in dat de projecties in een aantal

12

Hoofdstuk 2. Methodieken 13

groepen – subsets – opgedeeld worden. Tijdens een iteratie worden vanaf nu alle projecties

per subset doorlopen, waarbij voor elke subset het reconstructieschema van Figuur 1.3 gevolgd

wordt – een soort verdeel en heers strategie dus. Op deze manier moeten er slechts even veel

projecties in het geheugen gehouden worden als er hoeken in de subset zijn. Deze ingreep lijkt

op het eerste zicht de uitvoeringstijd te verhogen, maar wanneer de subsets mutueel exclusief

gekozen zijn, blijft de uitvoeringstijd grofweg dezelfde. Meer nog, het gebruik van subsets zorgt

voor een significante stijging van de convergentiesnelheid, waardoor er minder iteraties nodig

zijn en de uitvoeringstijd drastisch verlaagd wordt.

Een van de enige nadelen van het verdelen in subsets van de projecties, is dat hierdoor de

oplossingsruimte ook in verschillende stukken verdeeld wordt. In elke pass wordt in een andere

oplossingsruimte gezocht, die normaal gezien telkens overlapt met de overige oplossingsruimten.

Wanneer al deze oplossingsruimten exact een gemeenschappelijk gebied hebben, kan op deze

manier uiteraard zeer snel naar een correcte oplossing geconvergeerd worden. In de aanwezigheid

van ruis kan dit echter leiden tot een situatie waarbij er geen gemeenschappelijk stuk meer is,

waardoor de convergentie niet meer gegarandeerd is. Een tweede nadeel van het opdelen in

subsets is dat er sneller ruis geıntroduceerd wordt in de afbeeldingen naarmate de projecties in

meer subsets opgedeeld worden. Het zal dus nog belangrijker worden om het itereren op tijd te

stoppen.

Aangezien de invloed van de manier waarop de projecties verdeeld worden over de verschillende

subsets geen specifiek onderzoeksdoel is van deze thesis, worden deze gewoon sequentieel toege-

wezen aan de verschillende subsets1. Dit is een van de eenvoudigste manieren om de projecties

over de subsets te verdelen. Complexere methoden voor het onderverdelen van projecties in

subsets kunnen onder andere gevonden worden in [17] en [18].

2.2.1 OS-SART en SART

OS-SART[19] en SART[20] – Simultaneous Algebraic Reconstruction Technique – zijn beide

uitbreidingen van het ART algoritme voorgesteld in [21]. Deze categorie algoritmes zien het

reconstructie-probleem als het vinden van een afbeelding die voldoet aan de beperkingen die

opgelegd zijn door de gemeten2 data en de veronderstellingen die gemaakt worden over de

afbeelding en de data.

ART is gebaseerd op de Kaczmarz methode [22] voor het oplossen van stelsels lineaire vergelij-

kingen van de vorm Ax = b. In deze uitdrukking stellen de xi de onbekenden voor waarnaar de

vergelijkingen moeten opgelost worden. A is de coefficientenmatrix waarin de Aij de coefficienten

van de onbekenden zijn in de vergelijkingen. Tot slot stellen de bi de uitkomsten van de vergelij-

kingen voor. De Kaczmarz methode beschouwt elk van de vergelijkingen waaraan de onbekenden

moeten voldoen als een hypervlak. In de afwezigheid van ruis zullen al deze vlakken een uniek

snijpunt hebben, de oplossing van het stelsel. Er wordt gestart vanaf een willekeurig punt in

de oplossingsruimte, dat in een eerste stap geprojecteerd3 wordt op een van de hypervlakken,

1i.e. projectie 1 in subset 1, projectie 2 in subset 2 enz.2Tenzij anders aangegeven gaat dit over de data na correctie!3Projectie in de zin van lineaire algebra!

Hoofdstuk 2. Methodieken 14

gedefinieerd door een van de vergelijkingen. Het punt dat hierdoor bekomen wordt, wordt ver-

volgens geprojecteerd op een van de volgende hypervlakken. Dit proces herhaalt zich totdat

verdere projecties niets meer veranderen aan de positie van het punt.

Figuur 2.1: Illustratie van het ART algoritme

Figuur 2.1 geeft een grafisch voorbeeld van deze methode in een 2D geval. In de figuur is duidelijk

te zien dat de convergentiesnelheid enorm kan varieren afhankelijk van de vergelijkingen; hoe

orthogonaler de vergelijkingen zullen zijn, hoe sneller het algoritme zal convergeren. Voorts is

het belangrijk dat de hypervlakken ook effectief een snijpunt hebben. Als er ruis aanwezig is

in de acquisities, kan het zijn dat de doorsnede van de hypervlakken leeg is. In dit geval zal

het algoritme niet langer kunnen convergeren naar een unieke oplossing, maar blijven oscilleren

in de ruimte afgebakend door de verschillende hypervlakken. Indien de hoeveelheid ruis relatief

beperkt blijft, zal de oplossing die bekomen wordt door het algoritme gewoon stop te zetten

echter dicht genoeg liggen bij de unieke oplossing die in een ruisloos geval zou zijn bekomen.

Het belangrijkste nadeel van deze aanpak is dat het onmogelijk is om een statistisch model van

de data te incorporeren[13].

OS-SART en SART zijn uitbreidingen van ART in de zin dat, waar ART slechts 1 pixel van

een projectie gebruikt bij een update, zij de bijdragen van alle projecties gebruiken. Meer nog,

Hoofdstuk 2. Methodieken 15

OS-SART en SART updaten per iteratie alle voxels in de afbeelding, waar ART dit maar voor 1

voxel per keer doet1. In essentie verschillen OS-SART en SART slechts weinig van elkaar. Het

enige verschil zit in het aantal subsets dat gebruikt wordt bij de reconstructie. SART gebruikt

per definitie slechts 1 projectie per subset, waar dit bij OS-SART kan varieren. Dit maakt SART

dus een bijzonder geval van OS-SART.

Formule 2.1 geeft de algemene expressie voor (OS-)SART. Uit de formule blijkt dat OS-SART

en SART het schema van Figuur 1.3 vrij exact volgen. Het berekenen van de fout gebeurt door

het verschil te nemen van de gemeten projecties (bi) met de voorwaartse projectie van de vorige

iteratie (xnk). Vooraleer deze fout teruggeprojecteerd wordt, wordt ze eerst nog genormaliseerd.

Na de backprojectie is er opnieuw een normalisatie, alvorens de additieve update plaatsvindt.

xn+1j = xnj +

1∑i′∈Sn

ai′j

∑

i∈Sn

aij

bi −∑k

aikxnk

∑k

aik(2.1)

2.2.2 OS-EM

OS-EM[17] – Ordered Subset Expectation Maximisation – is de ordered subset uitbreiding

van het ML-EM2 algoritme[23][24] dat gebaseerd is op het Maximum Likelihood criterium van

Fisher[25]. In tegenstelling tot de op ART gebaseerde algoritmes is ML-EM een statistisch al-

goritme. ML-EM beschouwt de transmissiedata als een realisatie van een Poisson-distributie3,

aangezien Poisson-ruis de dominante bijdrage levert in de ruis van CT-beelden[26]. Het ML-EM

algoritme gaat steeds dat beeld reconstrueren dat statistisch gezien de grootste kans heeft om

tot de gemeten projecties te leiden. Hierbij heeft het de eigenschap dat het een asymptotisch

efficient algoritme is, waardoor het minder vatbaar voor ruis zou moeten zijn. CT beelden zijn

echter inherent vrij ruizig, waardoor het beeld met de grootste kans om de gemeten projecties

te veroorzaken eveneens vrij ruizig zal zijn. Hierdoor is het belangrijk om het itereren op tijd

te stoppen, alvorens het algoritme convergeert naar een te ruizig resultaat.

L (Φ) = ln g(y|Φ) (2.2)

Q(Φ′|Φ

)= E

[ln f(s|Φ′)|y,Φ

](2.3)

Zoals blijkt uit de naam bestaat ML-EM uit twee delen; ML, wat staat voor Maximum Likeli-

hood, en EM, wat staat voor Expectation Maximisation. Wat ML-EM dus concreet wil bereiken,

is het maximaliseren van een aannemelijkheidsfunctie door middel van het maximaliseren van

een overeenstemmende verwachtingswaarde. Formules 2.2 en 2.3 zijn cruciaal om dit te berei-

ken. Er wordt verondersteld dat de projecties, de vector y, de incomplete data vormen, terwijl

gezocht wordt naar de complete data, vector s. De complete data zal zowel de incomplete als

de ontbrekende data, zoals het geprojecteerde object, bevatten. Op basis hiervan kan dan de

1Vandaar ook de benaming Simultaneous ART2Maximum Likelihood Expectation Maximisation3Deze redenering klopt echter niet helemaal, aangezien ML-EM werkt met de gecorrigeerde gemeten projecties.

Hierdoor zal de ruiskarakterisatie bij ML-EM niet helemaal juist zijn. Bij MLTR zal op dit vlak wel de juiste

redenering gemaakt worden.

Hoofdstuk 2. Methodieken 16

log-aannemelijkheidsfunctie L (Φ) opgesteld worden, die een maat geeft voor de aannemelijk-

heid dat een bepaalde set projecties y het resultaat is van de projectie van een object Φ. Door

formule 2.2 te maximaliseren, zal uiteindelijk een set waarden voor Φ bekomen worden, die

het beeld zullen schetsen dat statistisch de grootste kans heeft om tot de gemeten projecties te

komen. Er zijn verschillende mogelijkheden om L te maximaliseren, waarvan EM degene is die

bij ML-EM gebruikt zal worden. EM is een iteratieve methode waarbij elke iteratie gebeurt in

twee stappen. In een eerste stap wordt op basis van formule 2.3 Q(Φ|Φn) berekend, hetgeen

overeenkomt met het berekenen van het gemiddelde1 van de log-aannemelijkheidsfunctie van de

complete data, gegeven de schatting voor het object uit de vorige iteratie. In de tweede stap,

de maximalisatiestap, wordt dit gemiddelde gemaximaliseerd door die waarde voor Φ te zoeken

die Q(Φ|Φn) maximaliseert. Deze waarde wordt dan de Φn+1 die in de volgende iteratie zal

gebruikt worden. Het kan aangetoond worden[23] dat deze procedure L (Φ) in elke iteratie zal

laten toenemen.

OS-EM mag dan wel een veralgemening zijn van het ML-EM algoritme, het is echter geen echt

EM algoritme. Meer nog, convergentie van het OS-EM is nog steeds niet bewezen, al geeft het in

de meeste gevallen wel een gelijkaardig resultaat als ML-EM. Een bijkomend nadeel is, dat het

opdelen in subsets van de projecties zorgt voor extra ruis en ervoor kan zorgen dat het algoritme

begint te oscilleren rond een oplossing[13].

xn+1j =

xnj∑i′∈Sn

ai′j

∑

i∈Sn

aijbi∑

k

aikxnj

(2.4)

Formule 2.4 geeft de algemene expressie voor OS-EM. Ook OS-EM volgt het schema van figuur

1.3 vrij nauwkeurig. De fout wordt hier berekend door de gemeten projecties te delen door

de berekende projecties. In tegenstelling tot 2.1 voor (OS-)SART is er geen normalisatie van

de fout, deze is er wel na diens backprojectie. De update bij OS-EM is multiplicatief, hetgeen

betekent dat OS-EM een inherente positiviteitsbeperking bevat.

2.2.3 OS-ISRA

OS-ISRA is de ordered subset uitbreiding van ISRA[27][28][29] – Image Space Reconstruction

Algorithm. ISRA is eveneens gebaseerd op het ML criterium van Fisher en is daardoor ge-

lijkaardig aan het ML-EM algoritme. Het is ontstaan met de opkomst van PET en SPECT

scanners met een steeds kleinere axiale resolutie. Hierdoor moest overgeschakeld worden op

3D reconstructie en dreigden de datasets te groot te worden. Om dit te omzeilen creeerden

Daube-Witherspoon en Muehllehner ISRA. Het grote verschil tussen ISRA en ML-EM is het

verschillend iteratie-schema. Bij ISRA zijn de ‘Compare’ en ‘Backproject’ stappen omgewisseld,

met andere woorden de fout wordt niet langer in de projectieruimte berekend, maar in de beeld-

ruimte2. Dit heeft als gevolg dat er veel minder bewerkingen uitgevoerd moeten worden om

1Aangezien de complete data niet gekend is – indien dit wel zo was zou het probleem triviaal op te lossen

zijn – kan de log-aannemelijkheidsfunctie zelf niet berekend worden, dus moet genoegen genomen worden met het

gemiddelde ervan, dat wel berekend kan worden.2Vandaar de naam Image Space Reconstruction Algorithm

Hoofdstuk 2. Methodieken 17

de fout te berekenen. De backprojectie van de gemeten projecties kan eenvoudig op voorhand

berekend worden. Deze aanpassing zorgt er echter wel voor dat ISRA geen echt ML algoritme

meer is, ondanks de gelijkenissen. De convergentie is echter wel nog steeds gegarandeerd[29].

Formule 2.5 geeft de algemene uitdrukking voor de ordered subset uitbreiding van ISRA1. Het

is duidelijk dat het net als OS-EM om een multiplicatief algoritme gaat, waardoor het even-

eens een positiviteitsbeperking bevat. In tegenstelling tot OS-SART en OS-EM vindt er echter

geen normalisatie plaats. De afbeelding wordt rechtstreeks geupdatet met de in de beeldruimte

berekende fout.

xn+1j = xnj

∑i∈Sn

aijbi

∑i∈Sn

aij∑k

aikxnj

(2.5)

Door met subsets te werken ontstaat er nog een extra moeilijkheid wat betreft het op voorhand

berekenen van de backprojectie van de gemeten data. In plaats van slechts een enkele backpro-

jectie moet er voor elke subset een backprojectie berekend worden. Hierdoor kan de hoeveelheid

geheugen die nodig is om deze bij te houden zeer snel oplopen naargelang het aantal subsets

stijgt. Het is dus vooral bij kleine subsets voordeliger om deze backprojectie per iteratie te

berekenen.

2.2.4 OS-MLTR

MLTR[30] – Maximum Likelihood algorithm for Transmission tomography – is net als ML-

EM en ISRA gebaseerd op het ML criterium van Fisher. In tegenstelling tot de voorgaande

algoritmes, werkt MLTR echter niet op de gecorrigeerde gemeten data, maar rechtstreeks op de

ruwe gemeten data. Dit zorgt voor een veel nauwkeurigere ruismodellering dan bij ML-EM het

geval is. ML-EM vertrekt immers van de foute veronderstelling dat de logaritme van de data

een realisatie is van een Poisson-distributie, terwijl dit niet het geval is. Het is immers de ruwe

gemeten data die Poisson gedistribueerd is.

Uitbreidingen van MLTR blijken bijzonder goed te zijn in het verwijderen van beam-hardening2

artefacten en artefacten ten gevolge van metalen implantaten[32][33]. Het verbeterde acquisitie-

model van MLTR blijkt dus zeer beloftevol te zijn[32].

yi = bie−

∑kaikx

nk

xn+1j = xnj −

1

Dln

∑i∈Sn

aijyi

∑i∈Sn

aij yi

(2.6)

Formule 2.6 geeft de algemene uitdrukking voor de ordered subset uitbreiding van MLTR3. Deze

formule is enigszins verschillend van deze gebruikt in [30], [32] en [33], maar is wel volkomen

1Vanaf hier zal ISRA verwijzen naar de ordered subset uitbreiding, tenzij anders aangegeven.2Wanneer rontgenstralen doorheen een object gaan, worden stralen met lagere energie gemakkelijker geabsor-

beerd, waardoor de straling achter het object gemiddeld een hogere energie heeft. Dit kan leiden tot artefacten

in de reconstructie.[31]3Vanaf hier zal MLTR verwijzen naar de ordered subset uitbreiding, tenzij anders aangegeven.

Hoofdstuk 2. Methodieken 18

equivalent. MLTR in de vorm van 2.6 reduceert echter het aantal projecties en backprojecties

die per iteratie gemaakt moeten worden. Dit zorgt voor een snellere uitvoering en is daarom te

verkiezen boven de andere formuleringen. In 2.6 stelt yi de ruwe gemeten projectiedata voor, yi

de berekende projecties en bi de gemeten waarde zonder object. D is een normalisatiefactor.

2.3 Fantomen en metrieken

Om een performantieanalyse te kunnen uitvoeren zoals beschreven in 1.4 zijn er verschillende

metrieken en fantomen nodig. In dit werk werden een drietal fantomen gebruikt om een aantal

eigenschappen zoals ruisgevoeligheid, contrast en spatiale resolutie te kunnen opmeten. Van elk

fantoom werden 1024 projecties gemaakt voor reconstructie. In wat volgt zullen elk van deze

fantomen besproken worden met voor elk fantoom de metrieken waarop het betrekking heeft.

2.3.1 Ruis en Contrast

Voor het bepalen van de ruisgevoeligheid van de verschillende algoritmes werd een waterfantoom

gebruikt. Dit fantoom bestaat uit een cilinder die uniform gevuld wordt met water. Op deze

manier kan er een scan gemaakt worden van een volkomen homogeen ‘object’. Bij een volledig

ruisloze acquisitie, zou bij reconstructie het watervolume in theorie overal een constante waarde

moeten hebben. Wanneer er echter ruis aanwezig is bij de acquisitie, dan zal dit zich ook verta-

len naar het gereconstrueerde beeld. Aangezien het deel van de reconstructieafbeelding dat het

watervolume voorstelt normaal overal dezelfde waarde moet hebben, zal de standaardafwijking

van de waarden in dit deel gelijk zijn aan de standaardafwijking van de ruis. Deze standaard-

afwijking zal dan voor elke reconstructie gebruikt kunnen worden om met behulp van 2.7 de

signaal-ruisverhouding te berekenen.

SNR =µbeeldσwater

(2.7)

Het bepalen van het contrast gebeurt door het scannen van een fantoom met laag contrast.

Dit houdt in dat het fantoom op zijn minst twee aan elkaar grenzende volumes heeft met een

dichtheid die slechts minimaal verschilt. In dit werk werd gebruik gemaakt van een QRM M32-

LC-18 fantoom[34]. Dit is een cilindrisch fantoom uit hars waarin vier smalle cilinders zitten.

Twee van deze cilinders hebben een diameter van 2.5 mm, de andere twee een diameter van

1 mm. De vier cilinders zijn twee aan twee uit een ander materiaal gemaakt: de ene soort

heeft een verschil van ∼40HU met de achtergrond, de andere soort verschilt ∼80HU van de

achtergrond. Figuur 2.3 geeft een schematische voorstelling van het fantoom en formule 2.8

geeft de uitdrukking waarmee de contrast-ruisverhouding berekend kan worden. Hierin stelt SA

het signaal voor van een cilinder en SB het signaal van de hars die de cilinders omhult.

CNR =|SA − SB|σwater

(2.8)

Signaal-ruisverhouding en contrast-ruisverhouding zijn nauw aan elkaar verwant; hoe beter de

signaal-ruisverhouding is, hoe beter ook de contrast-ruisverhouding zal zijn. Er is echter een

ondergrens voor de SNR vanaf waar het voor het menselijk oog niet langer mogelijk is om

Hoofdstuk 2. Methodieken 19

met 100 % zekerheid objecten van elkaar te onderscheiden. Rose kwam reeds in 1948 tot de

vaststelling dat deze ongeveer op een SNR van 5 ligt[35]. Het zal dus weinig zinvol zijn om

contrast te bekijken op beelden waar de SNR lager ligt dan deze ondergrens.

Figuur 2.2: Laag contrast fantoom

2.3.2 Resolutie

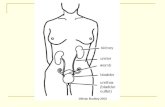

Voor het beoordelen van de resolutie wordt gebruikt gemaakt van een draadfantoom. Dit is een

fantoom waarin zich een dunne draad bevindt in lucht of een of andere vloeistof. Hier werd een

QRM M32-Wire fantoom[34][36] gebruikt. Bij dit fantoom zijn er twee wolfraam draden met

een diameter van 10 µm gespannen in lucht. Dit zorgt ervoor dat er een groot contrast is tussen

de draden en hun omgeving, waardoor er betere metingen gedaan kunnen worden. De eerste van

de twee draden bevindt zich dicht bij het centrum van het fantoom, het andere ligt in de buurt

van de rand. Op die manier kunnen er zowel resolutiemetingen in het midden, als meer naar

buiten toe gedaan worden. Dit is belangrijk aangezien de resolutie van een CT-beeld normaal

gezien beter is in het centrum dan erbuiten. Figuur 2.3 geeft een schematische voorstelling van

het fantoom.

Om uitspraken te kunnen doen over de resolutie, wordt gebruik gemaakt van de PSF1. Aan

de PSF van beide draden wordt een Gaussiaan gefit. Van deze Gaussiaan wordt dan telkens

de FWHM2 berekend. Hoe kleiner de FWHM is, hoe nauwkeuriger het algoritme zal zijn. De

FWHM zal steeds in twee richtingen gemeten worden; in radiale en in tangentiale richting.

2.4 Invloed van het startbeeld

Zoals Figuur 1.3 al aangaf, heeft een iteratief algoritme steeds een startbeeld nodig voor de

reconstructie. De keuze van een bepaald startbeeld kan een significante invloed hebben op

1Point Spread Function: het signaal dat bekomen wordt wanneer een puntbron aangelegd wordt aan het

systeem, hetgeen hier overeenkomt met het scannen van een zeer dunne draad.2Full Width at Half Max: de breedte van de Gaussiaan op het punt waar de piek de helft van zijn maximale

hoogte bereikt.

Hoofdstuk 2. Methodieken 20

Figuur 2.3: Draad fantoom

de convergentiesnelheid van het algoritme. Er zijn veel mogelijkheden en in dit werk zullen

er enkele onderzocht worden. De startbeelden kunnen in twee categorieen opgedeeld worden;

low-pass beelden en high-pass beelden.

Een egaal beeld is de meest eenvoudige keuze voor een startbeeld. In dit geval hebben alle

voxels in het beeld dezelfde waarde. Voor additieve algoritmen wordt dit een beeld dat volledig

bestaat uit nulwaarden. Multiplicatieve algoritmen hebben een niet-nul waarde nodig, aange-

zien voxels die op nul gezet worden, niet meer verder kunnen geupdatet worden. De precieze

waarde heeft weinig invloed op het resultaat, maar wordt voor de eenvoud het beste niet te hoog

genomen. In dit werk werd een waarde van 100 gehanteerd. Dit is een low-pass startbeeld.

Een tweede mogelijkheid is een random startbeeld. Hierbij hebben de voxels elk een random

waarde. Bij multiplicatieve beelden zullen deze random waarden opnieuw verschillend van nul

moeten zijn. Dit is het enige high-pass startbeeld.

Een derde mogelijkheid bestaat eruit om eerst een analytische reconstructie uit te voeren

en vervolgens dit FBP beeld te gebruiken als startbeeld voor de iteratieve reconstructie. Op

deze manier zal er minder lang geıtereerd moeten worden, aangezien er gestart wordt van een

beeld dat al veel dichter zal liggen bij het optimum waarnaar geıtereerd wordt. CT-beelden zijn

inherent low-pass, dus ook dit startbeeld is low-pass.

De laatste mogelijkheid die onderzocht zal worden is een multiresolutionele aanpak. Bij

deze aanpak wordt van een egaal beeld gestart, maar de eerste iteratie wordt uitgevoerd op een

lagere resolutie. Het resultaat van deze eerste iteratiestap wordt daarna herschaald tot normale

grootte en gebruikt als startbeeld voor de verdere iteraties. Op deze manier wordt er heel snel

een initieel, lowpass beeld gegenereerd, hetgeen voor een reductie van de ruis zal zorgen.

Figuren 2.4 tot 2.7 geven een voorbeeld van elk startbeeld dat onderzocht zal worden. Het

egale startbeeld in figuur 2.4 is zoals te verwachten valt weinig bijzonder; het heeft overal

dezelfde grijswaarde. Interessanter is het random startbeeld in figuur 2.6. Dit beeld ziet er

Hoofdstuk 2. Methodieken 21

Figuur 2.4: Egaal startbeeld

Figuur 2.5: FBP startbeeld

Figuur 2.6: Random startbeeld

Figuur 2.7: Multiresolutioneel startbeeld

eigenlijk gewoon uit zoals een egaal beeld, waar extreem veel ruis op zit. Een egaal startbeeld

daarentegen, kan beschouwd worden als een startbeeld waar helemaal geen ruis op zit. Het

verschil in ruis op het startbeeld zal uiteraard gevolgen hebben voor de hoeveelheid ruis die

effectief in de reconstructie aanwezig zal zijn, zoals zal blijken in 3.5. Figuur 2.5 en 2.7 zijn

dan weer vrij gelijkaardig, al is het multiresolutioneel startbeeld iets waziger dan het FBP

startbeeld. Het wazige van het multiresolutioneel startbeeld wordt veroorzaakt door het schalen

van het beeld. Hierbij wordt nearest neighbour interpolatie gebruikt omwille van de relatief

goede snelheid van deze interpolatiemethode. Het schalen zorgt er echter voor dat de scherpe

details uitgevlakt worden. Dit is echter positief, aangezien hierdoor de ruis, die bij het FBP

startbeeld licht aanwezig is, enigszins uitgevlakt wordt.

In hoofdstuk 3 zal de invloed van het startbeeld niet apart besproken worden, maar als onderdeel

van de overige parameters die onderzocht worden. Op die manier kan voor elke parameter

gekeken worden hoeveel invloed het startbeeld heeft op de prestatie van elk algoritme voor die

Hoofdstuk 2. Methodieken 22

bepaalde parameter.

2.5 Monte Carlo Simulatie

Initieel was het de bedoeling om ook Monte Carlo-technieken te onderzoeken. Deze zouden

kunnen gebruikt worden om een betere modellering van de projectie te bekomen. Met behulp van

Monte Carlo-technieken is het immers mogelijk om de rontgenstralen te modelleren, waardoor er

nauwkeurigere projecties kunnen berekend worden. Initiele testen met de software die hiervoor

ter beschikking stond gaven echter aan dat een enkele projectie over 1024 hoeken al een aantal

uur in beslag neemt. Aangezien er echter honderden projecties nodig zijn per iteratie zou dit

proces dus veel te veel tijd in beslag nemen. In samenspraak met de begeleider is er toen

afgesproken om deze piste niet verder te onderzoeken.

Hoofdstuk 3

Resultaten

3.1 Convergentie

Aangezien vier van de vijf algoritmes die zullen onderzocht worden, ordered subset varianten

zijn, moet er dus bepaald worden in hoeveel subsets de projectiedata zal worden opgedeeld.

Aangezien snelheid een belangrijke factor is, is het voordelig als er minder iteraties nodig zijn

om het gewenste resultaat te bereiken. Het aantal subsets dat er voor zorgt dat het algoritme

het snelst naar een oplossing convergeert, zal dus een goede keuze zijn. Om de convergentie te

kunnen testen, wordt elk algoritme verschillende malen uitgevoerd, telkens met een verschillend

aantal subsets. Elk algoritme voert acht iteraties uit alvorens het wordt stopgezet. Zoals zal

blijken uit de resultaten is acht iteraties ruim voldoende om een duidelijk beeld te krijgen van

de convergentie. Meer nog, voor het optimale aantal subsets zal na vijf iteraties het beeld niet

drastisch meer veranderen.

De metriek die werd gebruikt om de mate van convergentie te testen, is de NRMSE1 tussen

de opeenvolgende iteraties. NRMSE is een maat voor het verschil tussen twee verschillende

afbeeldingen. Formule 3.1 geeft de uitdrukking die toelaat om de NRMSE tussen twee opeen-

volgende iteraties te berekenen. In deze formule stellen de x1,i de grijswaarden van de pixels

van de eerste afbeelding en x2,i de grijswaarden van de pixels van de tweede afbeelding voor.

xmax en xmin zijn de maximale respectievelijk minimale grijswaarde die in beide afbeeldingen

voorkomt. Naarmate het algoritme convergeert zal de NRMSE tussen opeenvolgende iteraties

steeds kleiner worden. Het aantal subsets waarvoor de NRMSE het snelste daalt, is dus het

aantal subsets dat het algoritme het snelst laat convergeren.

NRMSE =1

xmax − xmin

√√√√√n∑i=1

(x1,i − x2,i)2

n(3.1)